1 固有函数

2 基本运算函数

3 三角函数

4 向量运算函数

5 format style

style - 输出显示格式

short (默认) | long | shortE | longE | ...

6 cylinder函数

[X,Y,Z] = cylinder 返回圆柱的 x、y 和 z 坐标而不对其绘图。返回的圆柱的半径等于 1,圆周上有 20 个等距点,底部平行于 xy 平面。

该函数以三个

分类目录归档:学习

style - 输出显示格式

short (默认) | long | shortE | longE | ...

[X,Y,Z] = cylinder 返回圆柱的 x、y 和 z 坐标而不对其绘图。返回的圆柱的半径等于 1,圆周上有 20 个等距点,底部平行于 xy 平面。

该函数以三个

一般情况下,我们将正常客户标记为0,违约客户标记为1。

单位根又叫(unit root)。

当一个自回归过程中: $$y_{t} = by_{t-1} + a + \epsilon _{t}$$ 如果滞后项系数b为1,就称为单位根。当单位根存在时,自变量和因变量之间的关系具有欺骗性,因为残差序列的任何误差都不会随着样本量(即时期数)增大而衰减,也就是说模型中的残差的影响是永久的。这种回归又称作伪回归。如果单位根存在,这个过程就是一个随机漫步(random walk)。

补充:解释变量(即滞后被解释变量)的系数应该有三种情况:

通过对损失函数引入正则项,避免模型的过拟合的情况。

正则化的分析:随着$\delta$取值的增大,系数$\theta$趋近于0

将原始样本通过函数进行高维映射,并作为特征进行模型输入,提高模型对于信息的提取能力

比如最常见的高斯核/RBF核(RBF:Radial basis function/径向基函数)

$$k(x,\mu_i,\lambda)=exp{(-\frac{1}{\lambda}||x-\mu_i||^2)}$$

转换过程: $$\phi(x)=[k(x,\mu_1,\

面对$N$个形式为$(x_i,y_i)$样本组成的样本集,线性回归就是为了寻找形式为$y_{N\times1}=X_{N \times d}\theta_{d\times 1}$的线性方程,使其能最大程度拟合样本,而第一步便是建立线性回归的损失函数/目标函数: $$Loss(\theta)= (y-X\theta)^T(y-X\theta) $$

其中$y$表示真实值,$X\theta$表示的预测值,所以损失函数$Loss(\theta)$表示的便是真实

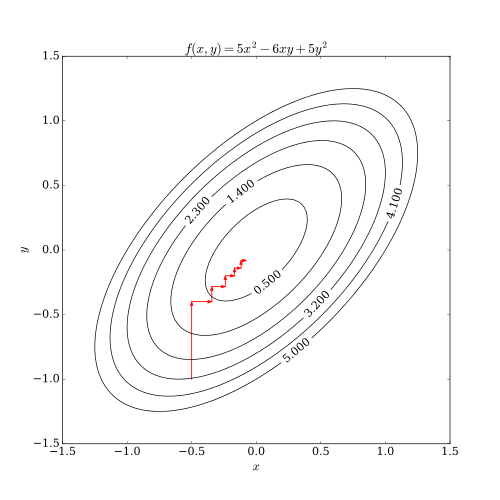

大部分机器学习模型的构建都是寻找最小损失函数的过程,而梯度下降法(Gradient Descent)便是一种常见迭代优化算法,用于寻找损失最小的参数解。

以简单二次函数为例进行算法的简单说明,模型形式

坐标下降法(英语:coordinate descent)是一种非梯度优化算法。算法在每次迭代中,在当前点处沿一个坐标方向进行一维搜索以求得一个函数的局部极小值。在整个过程中循环使用不同的坐标方向。对于不可拆分的函数而言,算法可能无法在较小的迭代步数中求得最优解。

为了加速收敛,可以采用一个适当的坐标系,例如通过主成分分析获得一个坐标间尽可能不相互关联的新坐标系,即自适应坐标下降法。

在统计学中,最小角回归(LARS)是一种将线性回归模型拟合到高维数据的算法

用 $T(\hat{\boldsymbol{\beta}})$ 表示 $\hat{\boldsymbol{\beta}}$ 的绝对值范数 $$T(\hat{\boldsymbol{\beta}})=\sum_{j=1}^m|\hat{\beta_j}|\tag{7}$$ 则Lasso即为下面的约束优化问题: $$\min S(\hat{\boldsymbol{\beta}}) \quad \text{s.t.} \quad T(\hat{\boldsymbol{\beta}}) \le t\tag{8}$$ Las