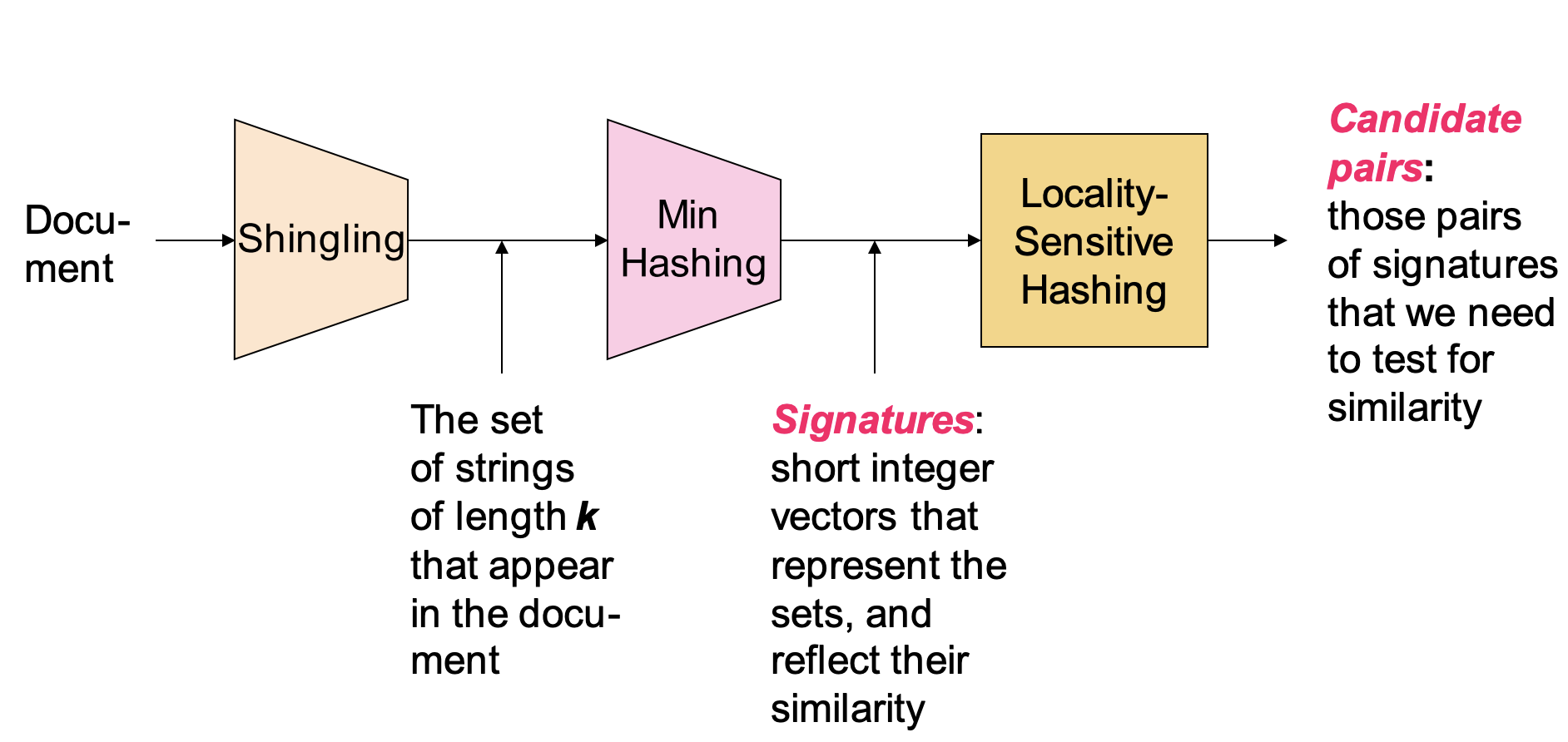

列线图(Alignment Diagram),又称诺莫图(Nomogram 图)

- 建立在多因素回归分析的基础上,将多个预测指标进行整合,然后采用带有刻度的线段,按照一定的比例绘制在同一平面上,从而用以表达预测模型中各个变量之间的相互关系

- 常用于多指标联合诊断或预测疾病发病或进展,也可以用于构建评分指标

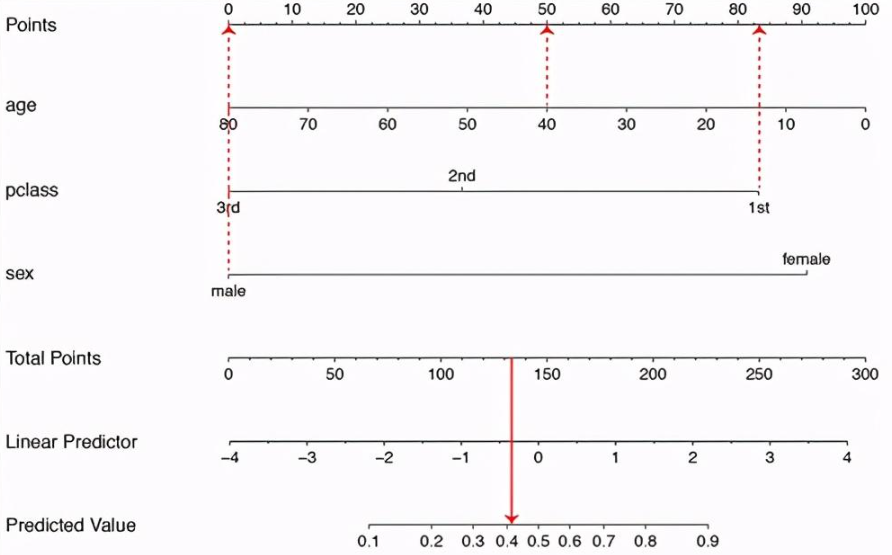

示例说明(以泰坦尼克邮轮数据集中,乘客的死亡二分类预测为例):

- 主要考虑特征为乘客的年龄(age),客舱等级(pclass)和性别(sex)

Points是每一个特征的评分参照,Total Points是所有特征的汇总评分参照Linear Predictor是汇总评分的线性映